Address

304 North Cardinal St.

Dorchester Center, MA 02124

Work Hours

Monday to Friday: 7AM - 7PM

Weekend: 10AM - 5PM

Address

304 North Cardinal St.

Dorchester Center, MA 02124

Work Hours

Monday to Friday: 7AM - 7PM

Weekend: 10AM - 5PM

概述 DeepSeek-R1模型在各项指标直逼甚至超越OpenAI及同类产品,迅速成为业界焦点。更令人惊喜的是该模型基于MIT协议免费开源,允许任何公司或个人自由商用,无需任何授权限制,一时间在AI界掀起了巨大波澜。 最近DeepSeek服务被外海攻击,有时候无法访问,既然Dee

DeepSeek-R1模型在各项指标直逼甚至超越OpenAI及同类产品,迅速成为业界焦点。更令人惊喜的是该模型基于MIT协议免费开源,允许任何公司或个人自由商用,无需任何授权限制,一时间在AI界掀起了巨大波澜。

最近DeepSeek服务被外海攻击,有时候无法访问,既然DeepSeek-R1是开源的,那么我们其实可以部署自己的DeepSeek-R1模型,如果再结合全栈AI助手,效果将更加完美。

废话不多说,直接上教程教怎么本地部署DeepSeek-R1服务。

一、安装ollama

用浏览器打开 https://ollama.com/

点击download按钮,下载ollama.

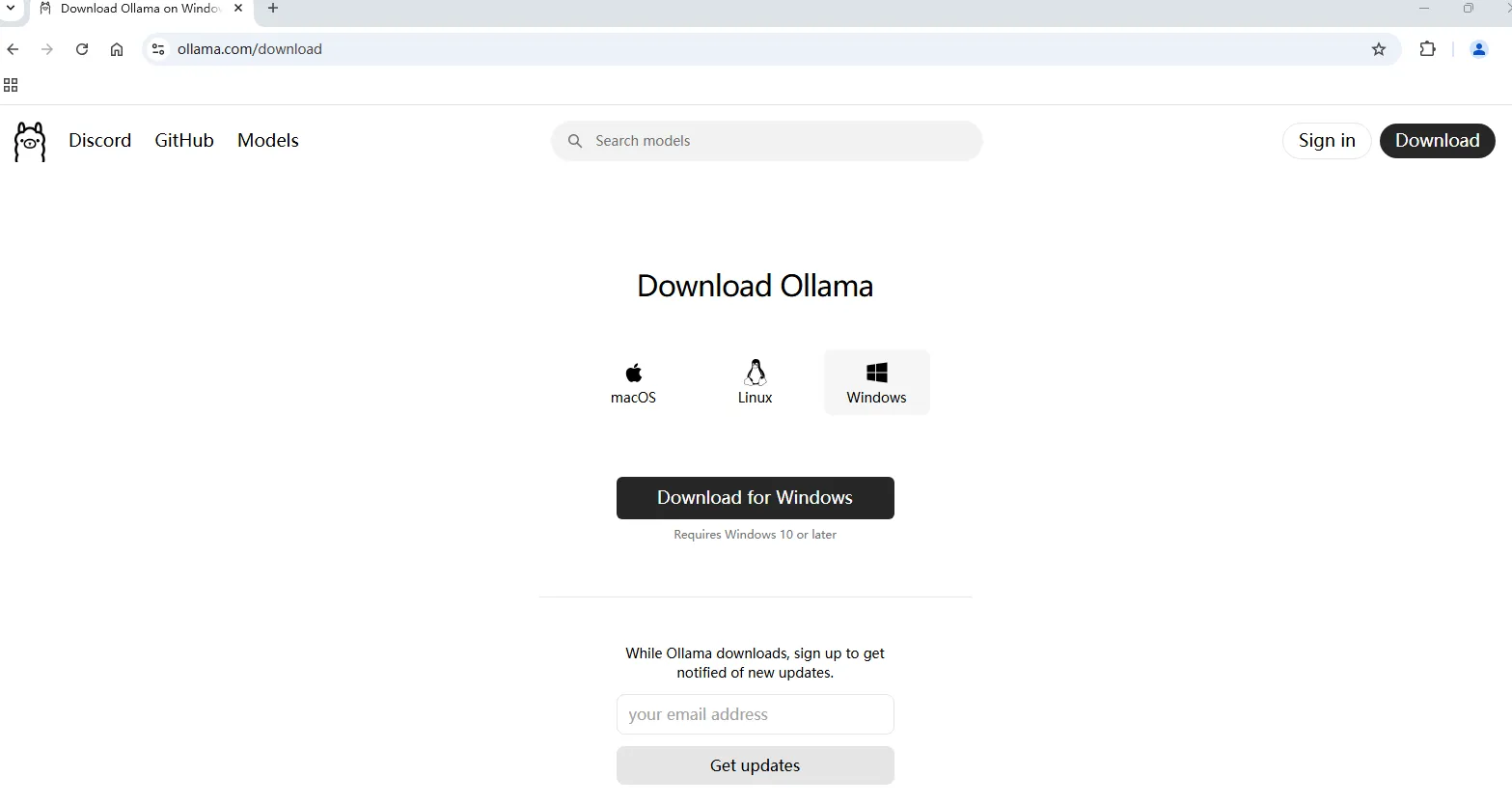

选择对应的操作系统版本下载。

点击Install安装。

二、根据配置安装合适的版本的deepseek R1模型

打开https://ollama.com/search 模型页:

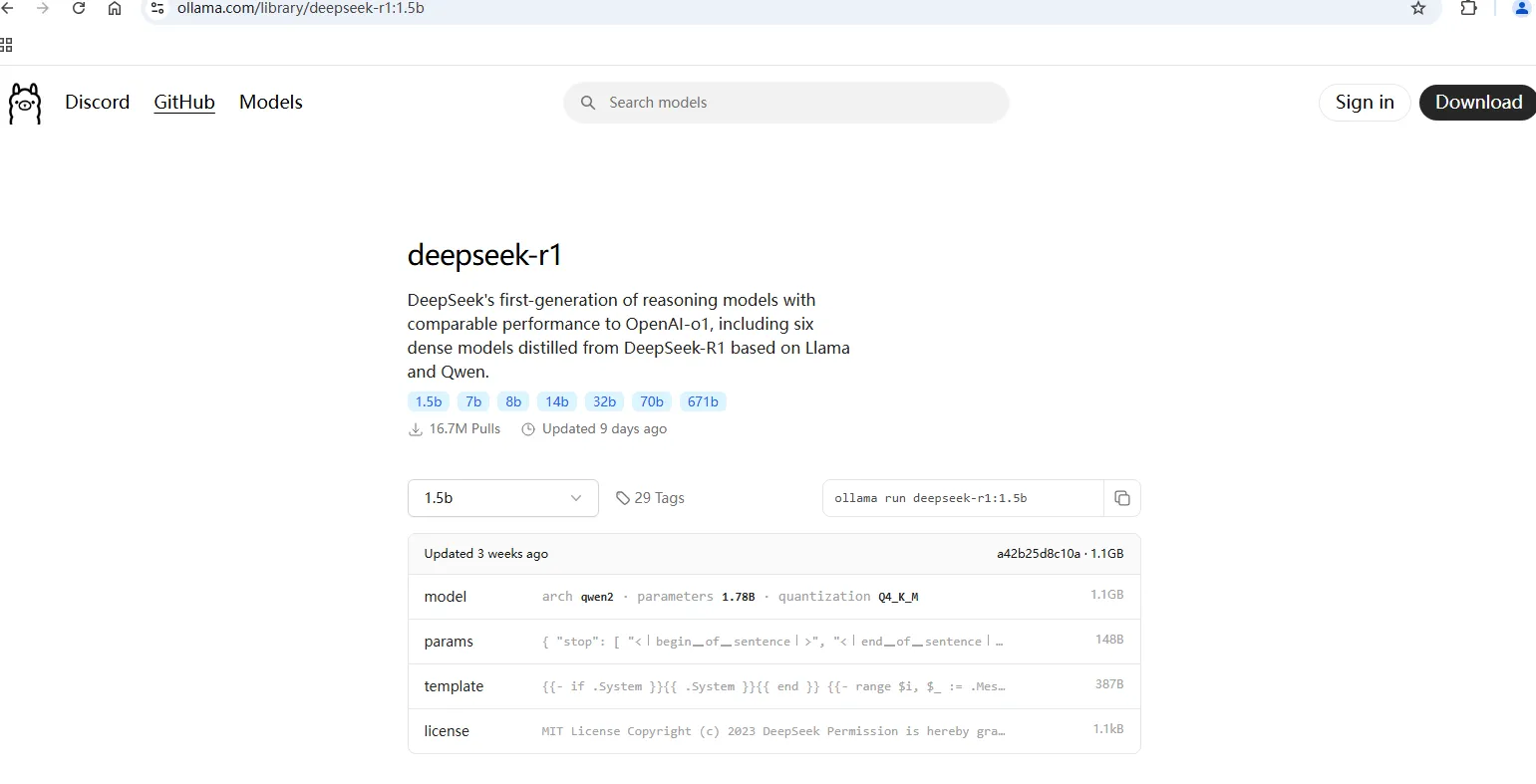

选择deepseek-r1模型: https://ollama.com/library/deepseek-r1

根据你电脑的硬盘及显存(内存)大小,选择不同大小参数的模型。这里为了演示,选择了1.5b的模型:

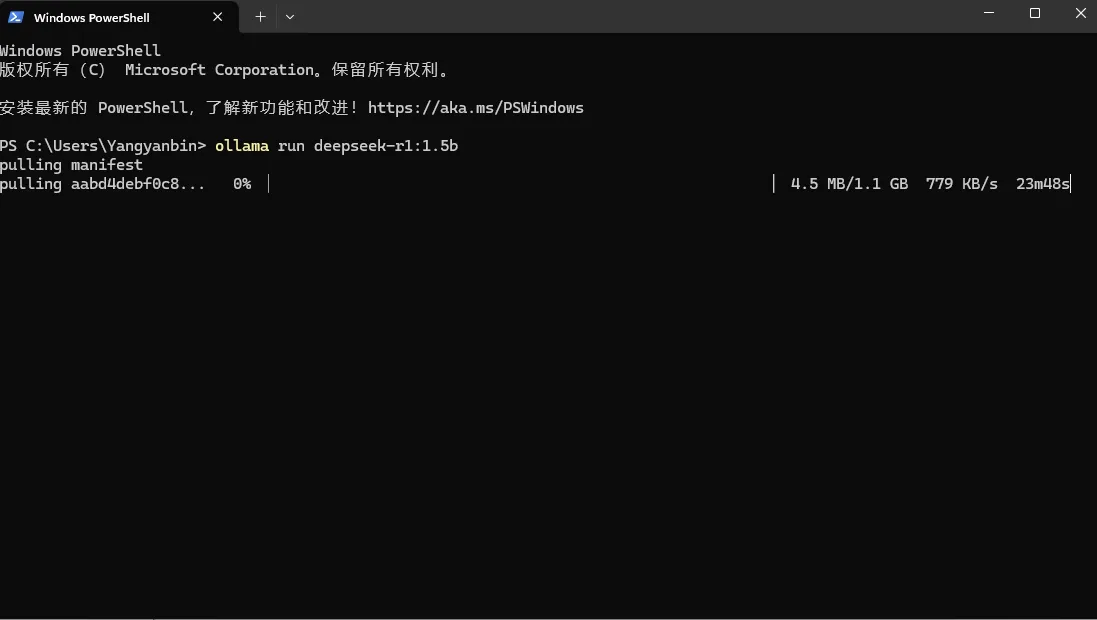

在终端中运行ollama run deepseek-r1:1.5b 进行安装deepseek-r1:1.5b模型。

根据显存选择合适的版本,有条件的建议上32B或者70B,效果非常好。

三、对话

安装完之后就可以直接在命令行对话了。

ollama 默认在命令行中对话,UI界面并不友好,如果配合全栈AI助手 也可以有更好的交互体验。

左上角选择“Ollma”模型,并在后面的自定义模型中输入你安装的deepseek-r1:1.5b。

OLLAMA调用 API跨域配置:

设置环境变量 OLLAMA_ORIGINS:

打开系统属性(可以通过Win+R,输入sysdm.cpl,然后回车)。

点击“高级”选项卡,然后点击“环境变量”按钮。

在“用户变量”区域,点击“新建”。

设置变量名为OLLAMA_ORIGINS,变量值为*(这表示允许所有来源的跨域请求)。

点击“确定”保存设置。

重启Ollama服务

确保关闭并重新打开命令行窗口,使新的环境变量生效。

重新启动Ollama服务。(结束所有ollama进程,再运行ollama run deepseek-r1:1.5b)

然后就可以开始愉快的对话了!!!